Anthropic publikuje poradnik: traktuj AI jak genialnego pracownika z… amnezją

Firma Anthropic, twórca chatbota Claude, opublikowała poradnik dotyczący skutecznego tworzenia poleceń dla sztucznej inteligencji.

W dobie rosnącej popularności chatbotów, umiejętność precyzyjnego formułowania zapytań, ma coraz większe znaczenie. Jak zatem pytać mądrze sztuczną inteligencję? Anthropic proponuje, by myśleć o AI w specyficzny sposób: jak o „genialnym, ale zupełnie nowym pracowniku, który cierpi na amnezję” i potrzebuje bardzo dokładnych instrukcji.

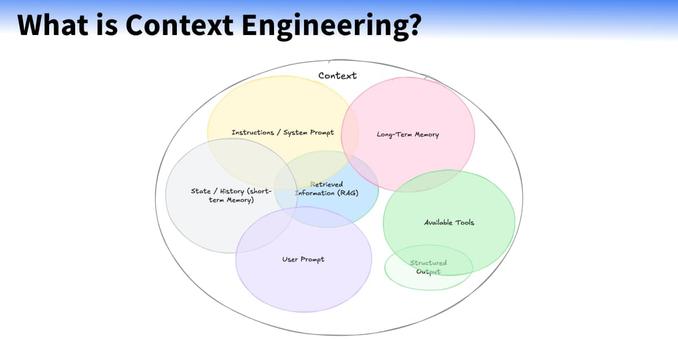

Pierwszą i najważniejszą zasadą, według poradnika, jest precyzja. Chatboty nie znają naszych oczekiwań, stylu pracy ani kontekstu zadania. Dlatego firma zaleca, aby w poleceniu jasno określić, dla jakiej publiczności przeznaczona jest odpowiedź, jaki jest jej cel końcowy, a także jak ma być sformatowana – na przykład w formie listy punktowanej. Równie istotne jest dostarczanie konkretnych przykładów. Technika ta, nazywana „multi-shot prompting”, pozwala znacząco poprawić jakość i spójność odpowiedzi, pokazując AI dokładnie, jakiego rezultatu oczekujemy.

Kolejna wskazówka to danie sztucznej inteligencji „przestrzeni do myślenia”. Chodzi o stosowanie tzw. techniki łańcucha myślowego (chain-of-thought), która polega na instruowaniu chatbota, aby rozłożył złożony problem na mniejsze kroki i przeanalizował je po kolei, zanim udzieli ostatecznej odpowiedzi. Takie podejście prowadzi do bardziej przemyślanych i trafnych rezultatów.

Niezwykle skuteczną strategią, którą podkreśla Anthropic, jest przypisywanie chatbotowi konkretnej roli, na przykład „redaktora wiadomości” lub „analityka finansowego”. Dzięki temu AI dostosowuje swój ton, styl i zakres wiedzy do powierzonej mu funkcji, co jest szczególnie przydatne w skomplikowanych zadaniach, wymagających specjalistycznej perspektywy. Taka technika pozwala precyzyjnie kontrolować charakter generowanych treści.

Poradnik odnosi się również do problemu tzw. halucynacji, czyli zmyślania informacji przez AI. Aby je ograniczyć, Anthropic sugeruje dwie proste metody. Po pierwsze, należy dać chatbotowi wyraźne pozwolenie na przyznanie się do niewiedzy, używając sformułowania „jeśli nie znasz odpowiedzi, powiedz, że nie wiesz”. Po drugie, można zobowiązać go do cytowania źródeł lub weryfikowania swoich twierdzeń poprzez znalezienie potwierdzającego je cytatu.

Zainteresowanym podrzucam link do rzeczonego poradnika od Anthropic (to żywy, tj. stale edytowany i rozwijany dokument).